, где

, гдеСовместно с монитором видеокарта образует видеоподсистему персонального компьютера. Видеокарта не всегда была компонентом ПК. На заре развития персональной вычислительной техники в общей области оперативной памяти существовала небольшая выделенная экранная область памяти, в которую процессор заносил данные об изображении. Специальный контроллер экрана считывал данные об яркости отдельных точек экрана из ячеек памяти этой области и в соответствии с ними управлял разверткой горизонтального луча электронной пушки монитора.

С переходом от черно-белых мониторов к цветным и с увеличением разрешения экрана (количества точек по вертикали и горизонтали) области видеопамяти стало недостаточно для хранения графических данных, а процессор перестал справляться с построением и обновлением изображения. Тогда и произошло выделение всех операций, связанных с управлением экраном, в отдельный блок, получивший название видеоадаптер. Физически видеоадаптер выполнен в виде отдельной дочерней платы, которая вставляется в один из слотов материнской платы и называется видеокартой. Видеоадаптер взял на себя функции видеоконтроллера, видеопроцессора и видеопамяти.

За время существования персональных компьютеров сменилось несколько стандартов видеоадаптеров: MDA (монохромный); CGA (4 цвета); EGA (16 цветов); VGA (256 цветов). В настоящее время применяются видеоадаптеры SVGA, обеспечивающие по выбору воспроизведение до 16,7 миллионов цветов с возможностью произвольного выбора разрешения экрана из стандартного ряда значений (640x480, 800x600, 1024x768,1152x864; 1280x1024 точек и далее).

Разрешение экрана является одним из важнейших параметров видеоподсистемы. Чем оно выше, тем больше информации можно отобразить на экране, но тем меньше размер каждой отдельной точки и, тем самым, тем меньше видимый размер элементов изображения. Использование завышенного разрешения на мониторе малого размера приводит к тому, что элементы изображения становятся неразборчивыми и работа с документами и программами вызывает утомление органов зрения. Использование заниженного разрешения приводит к тому, что элементы изображения становятся крупными, но на экране их располагается очень мало. Если программа имеет сложную систему управления и большое число экранных элементов, они не полностью помещаются на экране. Это приводит к снижению производительности труда и неэффективной работе.

Таким образом, для каждого размера монитора существует свое оптимальное разрешение экрана, которое должен обеспечивать видеоадаптер.

Таблица 2.3. Разрешение экрана монитора

|

Размер монитора |

Оптимальное разрешение экрана |

|

14 дюймов |

640x480 |

|

15 дюймов |

800x600 |

|

17 дюймов |

1024x768 |

|

19 дюймов |

1280x1024 |

Цветовое разрешение (глубина цвета) определяет количество различных оттенков, которые может принимать отдельная точка экрана. Максимально возможное цветовое разрешение зависит от свойств видеоадаптера и, в первую очередь, от количества установленной на нем видеопамяти. Кроме того, оно зависит и от установленного разрешения экрана. При высоком разрешении экрана на каждую точку изображения приходится отводить меньше места в видеопамяти, так что информация о цветах вынужденно оказывается более ограниченной.

В зависимости от заданного экранного разрешения и глубины цвета необходимый объем видеопамяти можно определить по следующей формуле:

, где

, где

Р — необходимый объем памяти видеоадаптера;

m — горизонтальное разрешение экрана (точек);

n — вертикальное разрешение экрана (точек);

b — разрядность кодирования цвета (бит).

Минимальное требование по глубине цвета на сегодняшний день — 256 цветов, хотя большинство программ требуют не менее 65 тыс. цветов (режим High Color). Наиболее комфортная работа достигается при глубине цвета 16,7 млн цветов (режим True Color).

Видеоускорение — одно из свойств видеоадаптера, которое заключается в том, что часть операций по построению изображений может происходить без выполнения математических вычислений в основном процессоре компьютера, а чисто аппаратным путем — преобразованием данных в микросхемах видеоускорителя. Видеоускорители могут входить, в состав видеоадаптера (в таких случаях говорят о том, что видеокарта обладает функциями аппаратного ускорения), но могут поставляться в виде отдельной платы, устанавливаемой на материнской плате и подключаемой к видеоадаптеру.

Различают два типа видеоускорителей — ускорители плоской (2D) и трехмерной (3D) графики. Первые наиболее эффективны для работы с прикладными программами (обычно офисного применения) и оптимизированы для операционной системы Windows, а вторые ориентированы на работу мультимедийных развлекательных программ, в первую очередь компьютерных игр и профессиональных программ обработки трехмерной графики.

Современные видеокарты

Видеокарта является основным элементом видеоподсистемы любого более или менее производительного компьютера (за исключением самых дешевых офисных систем с интегрированным в чипсет видео).

К основным компонентам видеокарты относятся: графический процессор (с легкой руки NVIDIA, именуемый GPU - Graphic Processing Unit), от возможностей которого во многом зависит производительность всей видеоподсистемы, и видеопамять (служащая для хранения различных элементов выводимого изображения, включая графические примитивы, текстуры и прочее).

Производительность видеоподсистемы определяет скорость обработки графической информации, выводимой на дисплей компьютера. По-настоящему объективных критериев оценки производительности видеокарт сегодня, к сожалению, не существует: и тесты, и многие игры, используемые для тестирования видеокарт, оптимизированы под видеочипы того или иного производителя и, тем самым, грешат некоторой тенденциозностью

В последние годы на рынке дискретных видеоадаптеров наблюдается двоевластие: конкурирующие друг с другом американская NVIDIA с модельным рядом видеокарт GeForce и ATI - канадское подразделение компании AMD (модельный ряд Radeon) не оставили остальным производителям места "под компьютерным солнцем". Кто лучший из первых двух? Сразу не Ответить. Ведь выходят все новые и новые поколения видеокарт NVIDIA и ATI, и ситуация на рынке меняется с калейдоскопической быстротой. Сегодня, например, в нише высокопроизводительных решений высшего уровня (пользующиеся популярностью в основном у различных компьютерных изданий), безусловно, лидирует NVIDIA с линейкой GeForce 8800, однако недавно пальма первенства принадлежала ATI Radeon 1950 и т.д. Что касается массовых продуктов, то видеокарты одного поколения от разных производителей примерно равны по возможностям, так что выбор решения от того или иного производителя определяется лишь предпочтениями пользователя.

Как правило, в настоящее время видеокарты имеют память 128 Мб и более, чего вполне достаточно для комфортной работы с любыми офисными приложениями, а также для просмотра видео. Больший объем видеопамяти требуется лишь в 3D-играх, а также при работе с профессиональными графическими пакетами.

Для работы с Windows Vista достаточно иметь графическую карту или

интегрированный чипсет с аппаратной поддержкой DirectX 9.0.

В минимальной конфигурации объем

видеопамяти должен составлять 64 Мб (минимум), а более продвинутый уровень,

позволяющий насладиться всеми прелестями трехмерного интерфейса (Aero Glass)

подразумевает использование видеокарты с поддержкой Pixel Shader 2.0, а также от

128 Мб памяти и выше.

Физические ускорители (PPU - Physics Processing Unit) являются узкоспециализированными устройствами, дополняющими традиционную связку CPU-GPU и освобождающие их от обязанности обсчитывать физические эффекты в современных трехмерных компьютерных играх. "Первой ласточкой" процессоров нового типа стал PPU PhysX, разработанный компанией Ageia в 2005 году.

К настоящему времени физические ускорители не получили сколько-нибудь серьезного распространения. В первую очередь, потому, что появились не вовремя - в пору экспансии двухъядерных процессоров, одно из ядер которых в игровых приложениях может достаточно эффективно обсчитывать всю физику. Таким образом, использование PPU сегодня не имеет особого смысла.

Важнейшими характеристиками любого современного графического процессора

являются:

- его тактовая частота - определяет максимальный объем работы, который процессор

может выполнить в единицу времени. Чем больше тактовая частота GPU, тем выше

производительность видеокарты;

- количество блоков шейдеров (пиксельных или вершинных процессоров, выполняющих

специальные программы) определяет возможности современных видеокарт по обработке

графических примитивов и, тем самым, производительность видеокарты. Пиксельные

шейдеры более актуальны, чем вершинные, поэтому зачастую - -- количество первых

в GPU превышает количество последних. Впрочем, разделение на пиксельные и

вершинные шейдеры в последнее время, в связи с выходом DirectX 10, теряет

актуальность. Все они заменяются едиными унифицированными шейдерными блоками,

способными, в зависимости от конкретной ситуации, исполнять роль как пиксельных,

так и вершинных шейдеров (а также и геометрических, которые появились в DirectX

10);

- количество блоков текстурирования (TMU), определяющих текстурную

производительность (скорость выборки и наложения текстур), особенно при

использовании трилинейной и анизотропной фильтрации. Наибольшее значение блоки

TMU имеют в относительно старых играх дошейдерной эпохи, хотя и сейчас они не

потеряли актуальности;

- количество блоков растеризации (ROP), осуществляющих операции записи

рассчитанных видеокартой пикселей в буферы и операции их смешивания (блендинга).

Как и в случае с блоками TMU, актуальность блоков ROP в период господства

шейдерной архитектуры несколько снизилась.

Все

приведенные выше характеристики видеочипов, безусловно, очень важны, однако было

бы большой ошибкой оценивать современные GPU только числом разнообразных блоков

и их частотой. Каждое очередное поколение современных GPU использует новую,

порой, принципиально новую архитектуру, в которой исполнительные блоки и их

взаимосвязи очень отличаются от старых, поэтому сравнивать GPU по количественным

параметрам оправданно только в рамках одного поколения.

Так как пропускной способности шины памяти в современных компьютерах

катастрофически не хватает для обеспечения нормального функционирования

высокопроизводительных видеокарт, то большинство из них оснащены собственной

памятью, используемой для хранения необходимых в процессе работы данных:

текстур, вершин, буферов и т.п. Исходя из этого, можно сделать вывод - чем

больше у видеокарты объем памяти, тем больше ее производительность (как любят

утверждать маркетологи). Но это не всегда верно!

Конечно, ситуации, когда больший

объем памяти приводит к росту производительности в играх, существуют, но они

достаточно редки и касаются в основном новейших, предельно требовательных к

системным ресурсам игр, работающих в самых высоких разрешениях. А большинство

массовых игр ограничивает аппетиты определенным объемом памяти, и превышение

этого порога не приведет к увеличению производительности. Гораздо более важными

параметрами видеопамяти являются ее производительность, то есть рабочая частота

и ширина шины.

Время доступа памяти (измеряется в нс) - величина, обратно пропорциональная

рабочей частоте видеопамяти. Чем меньше время доступа, тем больше максимальная

рабочая частота памяти:

Рабочая частота (МГц) = (1000/время доступа) * 2

Таким образом, зная время доступа

чипов памяти вашей видеокарты (которое указывается в маркировке чипа), всегда

можно оценить с большой долей вероятности максимальную частоту, на которой

память будет нормально работать. Это знание особенно важно, если вы планируете

разгонять видеокарту. Кроме этого, на время доступа памяти следует обращать

внимание и при покупке новой видеокарты (особенно - начального и среднего

уровней), ведь некоторые недобросовестные производители достаточно часто идут на

снижение себестоимости продукции именно за счет установки медленной

памяти.Ширина шины памяти, наряду с тактовой частотой, является важнейшим

параметром, определяющим производительность видеопамяти. Большая ширина

позволяет передавать большее количество информации в единицу времени из

видеопамяти в GPU и обратно, что, естественно, обеспечивает большую

производительность видеокарты (при прочих равных условиях). В современных

видеокартах ширина шины памяти составляет:

для бюджетных видеокарт - 64 или 128 бит;

для карт среднего уровня - 128 или 256 бит;

для самых дорогих High-End видеокарт - от 256 до 512 бит.

На видеокарты устанавливается видеопамять различных типов. Старая SDR-память практически нигде не встречается, да и сменившая ее DDR (с удвоенной относительно SDR производительностью) если и встречается, так только в самых дешевых бюджетных решениях. В массовых видеокартах наиболее распространена видеопамять типа DDR2 (и ее несколько улучшенный вариант GDDR3), пропускная способность которой удвоена по сравнению с DDR. Наиболее производительные видеокарты комплектуются видеопамятью GDDR4, которая помимо того, что работает в два раза быстрее, чем GDDR3, отличается пониженным напряжением питания, и, следовательно, уменьшенным энергопотреблением.

Память на видеокартах может быть как выделенной, так и выделяемой. Выделенная память означает, что видеопамять реализуется путем размещения на карте нескольких микросхем памяти. Все современные видеокарты, претендующие на сколько-нибудь сносную производительность, оснащаются выделенной памятью, хотя это и повышает их физические размеры, тепловыделение и, разумеется, цену. Видеокарты с выделяемой видеопамятью не имеют собственных чипов памяти, а, по мере необходимости, задействуют часть общесистемной памяти. Выделяемая память обычно не позволяет получить высокую производительность видеосистемы и используется в основном, в интегрированных и недорогих мобильных решениях, где вопросы экономичности выходят на первый план.

В последнее время в дешевых бюджетных видеокартах обрел популярность третий тип организации видеопамяти - гибридный, использующий возможности быстрого двунаправленного обмена по шине PCI Express. В таких видеокартах есть небольшой объем собственной видеопамяти, используемый для традиционных 2D-операций, а также для организации буфера RAMDAC. Когда этого объема недостаточно (в основном при запуске 3D-приложений), видеосистема добавляет к нему некоторый объем оперативной памяти. Когда отпадает потребность в дополнительной памяти, она высвобождается для общесистемных нужд. В видеокартах ATI такая память обозначается как HyperMemory, а в видеокартах NVIDIA - TurboCache. Скорость работы таких видеокарт, конечно, гораздо ниже, чем у классических систем с выделенной видеопамятью, однако гораздо выше, чем у тормозных решений с выделяемой памятью.

Системы аппаратного ускорения видео AMD Avivo и NVIDIA PureVideo HD осуществляют аппаратную декомпрессию HD-видеофайлов (30 кадров в секунду с разрешением 1920 x 1080), закодированных в H.264/AVC. Это позволяет существенно снизить требования к производительности центрального процессора и, тем самым, обеспечить плавное воспроизведение HD. Кроме того, обе технологии позволяют несколько улучшить качество картинки HD (впрочем, как и DVD) за счет подавления шума, сглаживания границ объектов и наложения различных фильтров.

HDCP (High-bandwidth Digital Content Protection - протокол защиты широкополосных цифровых данных) является одним из вариантов системы управления правами доступа к цифровым данным (DRM). HDCP разработан совместными усилиями компаний Intel и Silicon Image для управления доступом к аудио- и видеоданным высокой четкости (в основном, фильмов, распространяемых на носителях HD DVD и Blu-Ray DVD), и передаваемым по интерфейсам DVI и HDMI и призван не допустить их передачу в незашифрованном виде. Поддержка HDCP сегодня является обязательным условием соОтветствия любого устройства (в том числе видеокарт и мониторов) марке "HD Ready".

Интерфейсы видеокарт

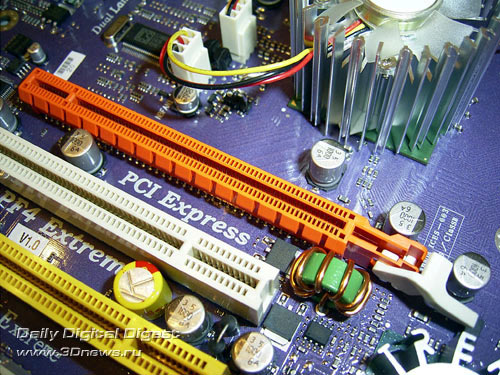

Стандартным интерфейсом для подключения видеокарт в настоящее время является шина PCI-Express 1.1 (PCIe или PCI-E). Последовательная передача данных в режиме "точка-точка", примененная в PCI-E, обеспечивает возможность ее масштабирования (в спецификациях описываются реализации PCI-Express 1x, 2x, 4x, 8x, 16x и 32x). Как правило, в качестве видеоинтерфейса используется вариант PCI-E 16x, обеспечивающий пропускную способность 4 Гб/с в каждом направлении, хотя изредка встречаются реализации PCI-E 8x (в основном в усеченных SLI- или CrossFire-решениях) и даже PCI-E 4x (в частности, так называемый PCI-Express Lite, реализованный на некоторых материнских платах ECS). При этом следует отметить, что во всех случаях, для установки видеокарт используется единый слот PCI-E 16x, а в усеченных версиях к нему подводится меньшее количество линий PCI-E.

В ближайшей перспективе ожидается массовое внедрение новой спецификации

PCI-Express 2.0 с увеличенной вдвое пропускной способностью (что в случае PCI-E

16x дает 8 Гб/с в каждом направлении). При этом PCIe 2.0 совместим с PCIe 1.1,

то есть старые видеокарты будут нормально работать в новых системных платах,

появление которых ожидается уже в 2007 году. Кроме того, спецификация

PCI-Express 2.0 расширяет возможности энергоснабжения до 300 Вт на видеокарту,

для чего на видеокартах вводится новый 2 x 4-штырьковый разъем питания.

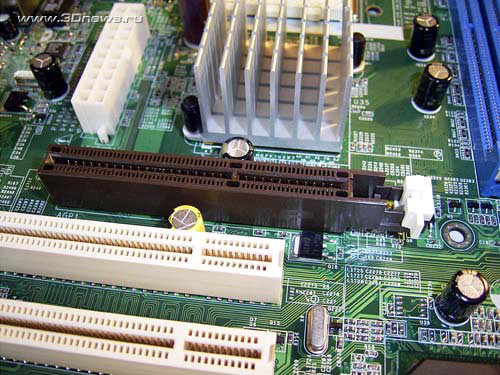

Устаревший,

но еще широко используемый видеоинтерфейс AGP (Accelerated Graphics Port - видео

порт с повышенной скоростью передачи данных), основан на параллельной 32-битной

шине PCI. В отличие от прототипа, она предоставляет прямую связь между

центральным процессором и видеочипом, а также более высокую тактовую частоту (66

МГц вместо 32 МГц), упрощенные протоколы передачи данных и другие.

Существует

несколько вариантов шины AGP, отличающихся по пропускной способности:

AGP 1х - 266 Мб/с;

AGP 2х - 533 Мб/с;

AGP 4х -1,07 Гб/с;

AGP 8х - 2,1 Гб/с.

Понятно, что

чем выше пропускная способность графического интерфейса, тем лучше. Но в

настоящее время разница в пропускной способности интерфейсов AGP и PCI-E 1.1 (не

говоря о PCI-E 2.0) если и влияет на производительность видеосистемы, то не

слишком, так что главное преимущество PCI-Express не в его высокой

производительности, а в возможности масштабирования, позволяющей устанавливать в

компьютер две, три и даже четыре видеокарты.

По стандарту AGP, потребляемый ток видеосистемы может достигать до 6 А по напряжению 3,3 В, до 2 А по 5 В и до 1 А по напряжению 12 В. Несложно подсчитать, что в итоге мы имеем до 42 Вт отдаваемой мощности. Более современный стандарт PCI-Express обеспечивает гораздо большую мощность питания: по шине питания 3,3 В потребляемый ток видеосистемы может достигать 3 А и до 5,5 А по 12 В, то есть всего до 76 Вт отдаваемой видеокарте мощности. Однако некоторым современным видеокартам и этого мало, поэтому на них могут устанавливаться один или два дополнительных 6-контактных разъема PCI-Express, каждый из которых способен обеспечить ток до 6 А по шине 12 В - всего до 72 или 144 Вт дополнительной мощности. Таким образом, интерфейс PCI-Express 1.1 способен обеспечить питание видеокарт, потребляющих до 220 Вт электроэнергии.

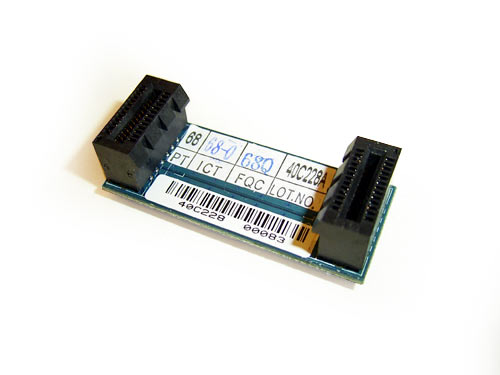

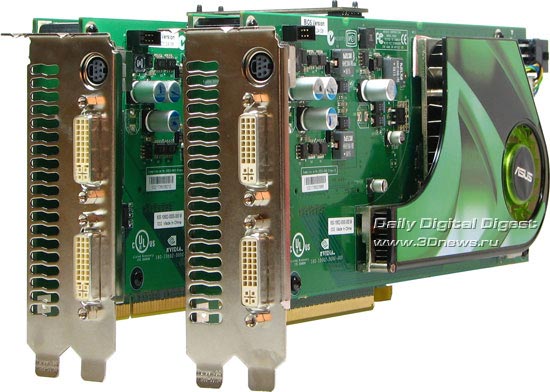

SLI (Scalable Link Interface - масштабируемый объединительный интерфейс) - программно-аппаратная технология NVIDIA, обеспечивающая установку и совместную работу двух видеокарт в режиме Multi-GPU Rendering. Нагрузка между ними распределяется динамически, что позволяет значительно увеличить производительность видеосистемы и получить высокое качество отображения трехмерной графики.

Для нормальной работы видеокарт в SLI-режиме, необходима материнская плата (пока только на чипсетах NVIDIA) с двумя графическими слотами, допускающими установку видеокарт с интерфейсом PCI-Express (NVIDIA GeForce 6x00 и более новых, причем обе видеокарты должны быть построены на одинаковых GPU). Для обмена информацией между ними, чаще всего используется специальный SLI- коннектор, хотя в отдельных случаях возможна связь через интерфейс PCI-E.

Во многих случаях использование SLI дает увеличение производительности 3D-приложений, хотя радикальное увеличение наблюдается в основном в играх, специально оптимизированных под эту технологию.

CrossFire является ответом компании ATI на инновацию NVIDIA SLI и также позволяет использовать две видеокарты для увеличения производительности видеосистемы.

Для подключения внешних видеоустройств на видеокартах, могут использоваться аналоговые интерфейсы VGA, RCA, S-Video и цифровые - DVI и HDMI:

до последнего

времени основным интерфейсом для вывода изображения на ЭЛТ и ЖК-мониторы являлся

аналоговый VGA-выход (15-контактный разъем D-Sub);

аналоговый разъем S-Video (или S-VHS) применяется в основном для вывода

компьютерного изображения на бытовые телевизоры и другую домашнюю видеотехнику.

Существенным недостатком этого интерфейса является то, что в современных

видеокартах могут использоваться несколько вариантов разъема S-Video, с разным

количеством контактов и не всегда совместимых друг с другом;

современные ЖК-мониторы, проекторы, телевизоры и плазменные панели могут

подключаться к видеокартам по цифровому видеоинтерфейсу DVI (Digital Visual

Interface). За счет того, что видеосигнал передается напрямую с видеокарты без

двойного цифро/аналогового преобразования, DVI обеспечивает неискаженную

передачу изображения, особенно заметную в высоких разрешениях. Интерфейс DVI

может быть как исключительно цифровой DVI-D, так и комбинированный DVI-I, в

котором наряду с цифровыми линиями имеются и аналоговые (VGA). Монитор с

аналоговым VGA-разъемом подключается к DVI-I через специальный переходник;

разновидностью DVI является интерфейс Dual-Link DVI, обеспечивающий поддержку

высокого разрешения (выше 1920 х 1200) по цифровому выходу DVI. Физически

Dual-Link DVI является объединением двух отдельных каналов DVI в одном кабеле,

что удваивает его пропускную способность;

мультимедийный интерфейс HDMI (High Definition Multimedia Interface)

присутствует в некоторых новых видеокартах, телевизорах и других домашних

мультимедийных устройствах. Главная особенность HDMI - возможность передавать по

одному кабелю на расстояние до 10 м наряду с цифровым видеосигналом еще и аудио

без потери качества. Благодаря этому количество соединительных проводов

(настоящий бич современных мультимедийных систем) существенно уменьшается.